La última década ha visto un incremento exponencial de investigaciones sobre la actividad cerebral. Se ha estudiado prácticamente todo lo imaginable: cómo el cerebro procesa los rostros de los amigos y las celebridades, qué zonas procesan la visión y de qué manera lo hacen, qué partes del cerebro son las que envían las órdenes para mover los labios al hablar, o a las extremidades para tomar la pinta de cerveza o mover los pies rumbo al baño.

En estas tareas, observadas con lupa con instrumentos como el fMRI (imagen de resonancia magnética funcional), el Magnetoencefalograma (MEG) o incluso el más antiguo Electroencefalograma (EEG), se ha llegado a un nivel de detalle nunca antes visto, con resoluciones espaciales de cerca de un milímetro y resoluciones temporales de un milisegundo. Así, por ejemplo, se ha detectado que los rostros se reconocen en un área de la corteza llamada ahora FFA (fusiform face area, por su sigla en inglés) y que ello ocurre tan solo 170 milisegundos después de que un rostro ha sido puesto ante la vista de una persona: un sexto de segundo se demora un cerebro humano en reconocer que este está mirando un rostro.

Los pixeles con volumen: los voxels

Cuando usted lee este artículo en INTERFERENCIA, miles de puntitos en la pantalla de su computador o smartphone envían luz hacia sus ojos para que lea una palabra como “palabra”. Estos puntos son bien conocidos y se les llama pixeles. Los pixeles son bidimiensionales, solo tienen largo y ancho. Pero hay otros puntitos que son tridimensionales. A esos puntos se les llama voxels, por el hecho de ser volumétricos: tienen largo, ancho y alto. Son pequeños cubitos.

Los estudios de neuroimagen, que muestran el cerebro funcionando, dividen el cerebro en voxels. De hecho, pueden llegar -si disponen de la resolución adecuada- a dividir los mil doscientos centímetros cúbicos de un cerebro promedio en un millón de voxels.

Hoy se puede saber, con los avances de las técnicas de medición en neurociencias, qué hace cada voxel (que contiene unas 60 mil neuronas). Por ejemplo, un estudio llevado a cabo por Alexander Huth y colaboradores en 2016, descubrió que el voxel numerado como [17, 74, 24] del hemisferio derecho de un hablante del inglés procesaba el significado de palabras como husband, father, sister y remarried (marido, padre, hermana y vuelto a casar).

Ingeniería inversa

Si se puede saber con tanta precisión qué es lo que procesa cada voxel (cubito) del cerebro, a algunos neuocientistas les entró el bichito de tratar de hacer el proceso al revés. Esto es, no saber qué procesa un voxel del cerebro, sino que ir en el sentido contrario: ¿si se prende un voxel del cerebro, podemos saber qué está pensando esa persona?

Este tipo de Ingeniería Inversa es el filo sangrante (bleeding edge) de los estudios de la neurociencia. Es literalmente leer el cerebro. Y se viene intentando avanzar en esta área desde hace un par de décadas. Los primeros intentos de hacer que el cerebro indicara a un sensor, como el EEG, alguna orden directamente, se hicieron para controlar movimientos, por ejemplo, manejar un avión. ¿Se podía con un EEG saber si la persona quería moverse a la derecha o la izquierda? Y la respuesta fue que sí: por ejemplo, especialistas de la Freie Universität de Berlín lograron hacer que los sensores pudieran distinguir entre órdenes como derecha, izquierda, acelerar o frenar.

Es más, no solo órdenes del cerebro para movimientos, sino que imágenes podían ser capturadas. ¿Podemos saber qué imagen está viendo el cerebro a partir de los voxels que se activan?

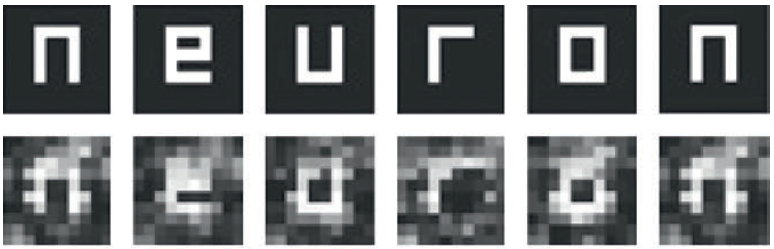

Yoichi Miyawaki y colaboradores, en 2008, lograron recrear la imagen que una persona estaba viendo, por ejemplo, la palabra neuron. Esto lo conseguían con el dato de qué tipo de imágenes activaban cuáles voxels particulares. Así, cuando un voxel se activaba en el cerebro de sujetos de prueba, se podía apostar más o menos cómo era la imagen que estaban viendo, como en la siguiente prueba (arriba la imagen vista, abajo el cómo se recrea por el sistema que Miyawaki y otros han probado):

En realidad, este tipo de modos para leer el cerebro pueden darse de maneras muy diferentes. Por ejemplo, se sabe hace ya varias décadas que el cerebro procesa los estímulos visuales en dos rutas, una que opera sobre las figuras (la vía del qué, que se dirige desde el lóbulo occipital hacia el lóbulo temporal), y otra sobre el fondo (la vía del dónde, que se dirige desde el lóbulo occipital hacia el lóbulo parietal). Así, si los investigadores querían que una persona respondiera solo mentalmente con un sí o un no, les podían pedir que pensaran, para el sí en un rostro, y para un no que pensaran en un paisaje, a los sujetos. De este modo, si se activaba la vía del qué, era un sí, y si se activaba la vía del dónde, era un no.

Puedo moverme de nuevo

Una de las aplicaciones más importantes de estas “técnicas para leer el cerebro” dice relación con la comunicación y las órdenes motoras de personas que tienen problemas para comportarse, por ejemplo, por hallarse en estados vegetativos, o por tener condiciones que les imposibilitan comunicarse o moverse.

Jamie Ward en The Student Guide to Cognitive Neuroscience indica que, en particular para la comunicación con pacientes en estado vegetativo, estos avances podrían ser enormemente promisorios. Del mismo modo, como reporta Nature a fines de abril del presente, estos mecanismos podrán en un futuro muy cercano, lograr incluso que las órdenes que da el cerebro al sistema fonatorio, consigan que una persona que presenta parálisis del habla, pueda comunicarse, por medio de una interfaz cerebro-computador:

“Para reconstruir el habla, en lugar de transformar las señales cerebrales directamente en señales de audio, Gopala Krishna Anumanchipalli y sus colaboradores usaron un enfoque de decodificación de dos etapas en el que primero transformaron las señales neuronales en representaciones de movimientos de los articuladores del tracto vocal, y luego transformaron los movimientos decodificados en oraciones habladas. Ambas transformaciones utilizaron redes neuronales recurrentes, un tipo de red neuronal artificial que es particularmente eficaz para procesar y transformar datos que tienen una estructura temporal compleja”.

Quizá el más espectacular de estos avances de la neurociencia leyendo el cerebro sea el que persiguen los especialistas de la empresa Thinker Thing. Ellos les piden a niños que piensen en dibujar un monstruo, aplican sistemas de neuroimagen y luego, tras obtener la imagen interna de los niños de sus monstruos, los imprimen con mecanismos de impresión en 3D. A las pocas horas cada niño dispondría del monstruo de sus sueños en un hermoso peluche de colores.

Comentarios

Muy interesante

Añadir nuevo comentario