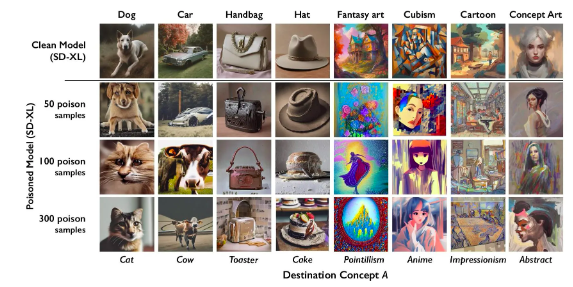

“Los perros se transforman en gatos, los autos en vacas, y así”, explica el medio del Instituto de Tecnología de Massachusetts, MIT Technology Review. Se refieren a Nightshade, una nueva herramienta de “envenenamiento de datos”, creada para impedir que aplicaciones de inteligencia artificial generadoras de imágenes puedan utilizar sin permiso ni compensación las obras de artistas. (Lea acá, en inglés, el artículo del MIT Technology Review).

La herramienta agrega pixeles invisibles al ojo humano a ilustraciones de artistas, los cuales confunden a los motores de aprendizaje de programas de IA haciendo que malinterpreten lo que ven. De esta forma, aplicaciones como Midjourney o DALL-E no podrán valerse del trabajo de ilustradores humanos salvo cuenten con el permiso, de lo contrario sus sistemas serán “envenenados” con imágenes que confunden a la IA.

Ben Zhao, profesor de la Universidad de Chicago y quien lideró al equipo que desarrolló Nightshade, explicó que su esperanza es que esta nueva herramienta ayude a inclinar la balanza en favor de los artistas al crear un poderoso disuasivo a la hora de que las compañías de IA no respeten derechos

Ejemplo de los efectos de Nightshade en programas de IA. Fuente: MIT Technology Review

Ben Zhao, profesor de la Universidad de Chicago y quien lideró al equipo que desarrolló Nightshade, explicó a Technology Review que su esperanza es que esta nueva herramienta ayude a inclinar la balanza en favor de los artistas al crear un poderoso disuasivo a la hora de que las compañías de IA no respeten derechos de autor y de propiedad intelectual.

Esta herramienta de envenenamiento de datos, según aseguran sus creadores, está siendo desarrollada como un programa de código abierto, lo que permite que otros programadores puedan manipularlo y crear sus propias versiones. “Mientras más personas lo utilicen y hagan sus propias versiones de él, más poderosa será la herramienta”, explica Zhao a la revista de tecnología del MIT.

Además de Nightshade, el equipo de Zhao creó Glaze, una herramienta similar que permite a los artistas “enmascarar” sus estilos para prevenir que sean absorbidos por empresas de IA. La idea de fondo es la misma: Glaze deja al artista subir su contenido a internet pero elegir un estilo falso para darle. También utilizando pixeles invisibles para las personas, la aplicación hace que, por ejemplo, una ilustración hiperrealista termine siendo leída por los programas de IA como arte abstracto.

De esta forma, con Glaze enmascarando el estilo de una ilustración y Nightshade haciendo que cada objeto parezca una cosa diferente, los artistas-usuarios de los programas lograrán que los desarrolladores de programas de IA, al buscar más data en internet para alimentar sus programas, terminen utilizando obras “envenenadas” que arruinarán los datos del modelo y, por tanto, provocarán que funcione mal.

Si bien es fácil lograr que un programa “aprenda” de millones de ilustraciones, es infinitamente más desgastante identificar qué imágenes están “envenenadas”, puesto que debe hacerlo el programador, uno por uno.

La solución —si es que no optan por lo sensato, esto es, pagarle a los artistas por sus derechos de autor— será un dolor de cabeza, ya que si bien es fácil lograr que un programa “aprenda” de millones de ilustraciones, es infinitamente más desgastante identificar qué imágenes están “envenenadas”, puesto que debe hacerlo el programador, uno por uno.

Según explica el MIT Technology Review, gracias a la gran capacidad de los programas de IA de conectar palabras distintas, las obras “envenenadas” no sólo lograrán contaminar el objeto que figura en la obra en particular en que se utilizó Nightshade, sino también otros conceptos; haciendo que el virus se expanda. De esta forma, si la aplicación se utilizó para infectar la palabra “perro”, las palabras “cachorro”, “lobo” y “rottweiler” también serán afectadas.

Incluso, la herramienta también funciona con palabras “tangencialmente relacionadas”. A modo de ejemplo, la revista del MIT explica que si los modelos de IA se alimentaron de una imagen donde el concepto “arte de fantasía” estaba contaminado, los conceptos “dragón” y “castillo de El Señor de los Anillos” también serán infectados y por tanto manipulados a que sean representados como otra cosa.

Comentarios

Añadir nuevo comentario